Wiele mediów dziś donosi, że robot zabił człowieka w fabryce Volkswagena. Równie popularne są informacje o rasistowskiej aplikacji Google. Tak naprawdę były to tylko wypadki, ale jako ludzie wciąż nie możemy przełknąć zniewagi lub ataków ze strony maszyn.

Z danych GUS wynika, że tylko w Polsce w I kwartale 2015 roku śmiertelnym wypadkom przy pracy uległo 66 osób. Rocznie w naszym kraju liczba takich wypadków idzie w setki, a na całym świecie wypadki przy pracy pochłaniają miliony ofiar. Wiele z nich wiąże się z maszynami i zazwyczaj o tych wypadkach nie pisze się w globalnych mediach.

Robot zabił

Powiedzcie zatem, dlaczego dziś wiele dużych mediów pisze o wypadku w fabryce Volkswagena? Doszło tam do tego, że robot zabił człowieka. Maszyna złapała mężczyznę i cisnęła nim o metalową płytę. Przedstawiciel Volkswagena Heiko Hillwig już wyjaśnił, że do wypadku najprawdopodobniej doszło z powodu błędu ludzkiego. Financial Times ustalił, że chodziło o robota starszego typu, który nie był jednym z tych robotów nowej generacji, które pracują ramię w ramię z pracownikami.

Dlaczego ten wypadek był opisywany w największych mediach? Chyba jakoś trudno nam znieść myśl, że robot mógł zabić człowieka. Teoretycznie był to po prostu wypadek z maszyną. W fabrykach i na placach budowy jest dużo maszyn, które mogą zabić, ale żeby to zrobił robot? Jakoś trudniej nam to znieść.

Być może na sukces tej historii miało wpływ jeszcze coś. Dla Financial Timesa pracuje reporterka Sarah O'Connor, która została przydzielona do tego tematu. Tak się składa, że w filmie Terminator, który przecież opowiada o buncie maszyn, była postać fikcyjna o nazwisku Sarah Connor. Reporterka poinformowała o wypadku na Twitterze i ten wpis zrobił furorę z powodu zbieżności nazwisk.

Niezależnie od powyższego musicie przyznać, że nagłówki w rodzaju "robot zabił człowieka" brzmią nieco inaczej niż stwierdzenie, że "dźwig zabił człowieka". Podświadomie zaczynamy myśleć, że robot zrobił coś złego, podczas gdy on mógł jedynie wykonać zaprogramowaną sekwencję ruchów albo w wyniku awarii wykonał ruchy nieprzewidziane.

Znów rasistowska aplikacja

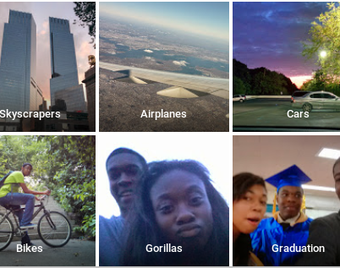

Przejdźmy teraz do innego popularnego dziś newsa. Aplikacja Google Photos błędnie oznaczyła czarnych ludzi jako "goryle". Pisał o tym m.in. Wall Street Journal. Oczywiście niektórzy ludzie dopatrzyli się w tym rasizmu albo przynajmniej bardzo się zezłościli. Firma Google przeprosiła i zapowiedziała wprowadzenie niezbędnych poprawek.

fot. z Twittera (Jacky Alciné)

To, że algorytm myli osobę czarnoskórą z małpą, nie jest niczym nowym. W maju pisałem o rozpoznawaniu obrazów na Flickrze, dzięki któremu zdjęcie Afroamerykanina zostało otagowane jako "małpa" i "zwierzę". Co więcej, zdjęcie bramy obozu koncentracyjnego w Dachau oraz zdjęcie wejścia do obozu w Oświęcimiu zostały oznaczone tagiem "sport".

Właściwie nie powinno być żadnej afery, a Google nie powinna przepraszać. Nawet najlepszy program mógłby pomylić małpi pysk z twarzą człowieka, a niestety goryle mają dość ciemną skórę. Jestem pewien, że gdyby istniały białoskóre goryle lub szympansy, Google Photos pomyliłaby z małpą niejednego białego. Ba! W przeszłości algorytm Google Photos potrafił mylić konie z psami, więc mylenie gatunków ssaków już przerabialiśmy. Oczywiście wszyscy rozumiemy, że ludzie będą bardziej tolerować mylenie dwóch gatunków zwierząt niż mylenie ludzi ze zwierzętami.

Wbudować kulturę w maszynę?

Google będzie wprowadzać poprawki, czyli co zrobi? Firma może zmusić swoje oprogramowanie do częstszego porównywania osób czarnoskórych i małp, aby poprawić jakość rozpoznawania. Firma może też uwrażliwić algorytm na kolor skóry i sprawić, że będzie on ostrożniejszy w oznaczaniu zdjęć z ciemnymi twarzami. Pytanie brzmi, czy dokonywanie takiego różnicowania nie będzie już rasizmem. Oczywiście żartuję. Firma Google musi po prostu sprawić, aby jej algorytmy reagowały lepiej w sytuacjach, które mogą wzbudzać kontrowersje. Firma musi jakby wbudować warstwę kulturową do bezdusznego algorytmu. W przeciwnym razie ludzie mogą się denerwować.

Czy wiecie, kto napędził zamieszanie wokół "rasistowskiego" Google Photos? Był to Jacky Alciné, który napisał o sprawie na Twitterze, skarżąc się na sposób oznaczenia jego znajomych. Jacky zajmuje się m.in. programowaniem. Z pewnością ma świadomość, że oprogramowanie zawsze może robić psikusy i nie musi w tym być złej woli jego twórcy. Mimo wszystko właśnie ten człowiek zdenerwował się na "rasistowskie" Google Photos.

W przyszłości maszyny i algorytmy będą częściej wykonywać złożone zadania. Słyszeliście o robotach dziennikarzach? Czy pewnego dnia automatyczny redaktor nie napisze czegoś rasistowskiego albo bardzo niepoprawnego? Czy nie pojawi się potrzeba wprowadzania warstw kulturowych do kolejnych technologii? A co z robotami, które mogą "zabijać"? Co będzie, jeśli pewnego dnia zdarzy się wypadek przy maszynie naprawdę wysoce autonomicznej? Czy będziemy w stanie obiektywnie oceniać te zdarzenia?

Artykuł może zawierać linki partnerów, umożliwiające rozwój serwisu i dostarczanie darmowych treści.

|

|

|

|

|

|

|

|

Stopka

- O nas | Redakcja

- Wywiady | Porady

- Prywatność & cookies

- Mapa serwisu | RSS

© 1998-2026 Dziennik Internautów Sp. z o.o.