Jak wygląda struktura dyskusji o fake news w Polsce? Korzystając z algorytmów do przetwarzania treści agencja badawcza IRCenter poddała analizie treści tweety wprost odwołujące się do fakenews i pokazała jak wygląda cykl życia fake news w internecie.

Fake news został okrzyknięty słowem roku 2017. Najwięksi – Google, Facebook – zostali zmuszeni do blokowania fake-newsów. W Polsce również i Ministerstwo Cyfryzacji weszło z nimi w dialog w tej kwestii. W internecie pojawiły się systemy machine learning i sztucznej inteligencji do automatycznego przetwarzania języka. Dla komputerów to jednak niełatwe zadanie; bardzo trudno zrobić algorytm, który umiałby precyzyjnie nie tylko zidentyfikować – jaką treść należy sprawdzić, ale i – faktycznie ją sprawdzić.

W świecie walki z fake news obecnie dla największych graczy liczą się wciąż żywi ludzie (ang. fact-checkers). Facebook i Google zatrudniają tysiące ludzi do faktycznego czytania prawdziwych treści i weryfikowania ich zgodności z odpowiednimi regulacjami. Rządy namawiają Facebooka i Google, żeby rozwijały się współprace z lokalnymi watchdogami / fundacjami / think-tankami dziennikarskimi. W różnych krajach Facebook i Google wprowadzają również zwykłym użytkownikom przyciski do zgłaszania fake newsów.

Komputery nie są może jeszcze optymalne do faktycznego rozumienia treści, ale świetnie sobie radzą z automatyczną analizą językową. Na przykład taką, która została okrzyknięta przez innych jako fake news. Korzystając z rozwiązań do NLP (natural language processing) poddaliśmy analizie treści w social media opublikowane w 2017 roku, które posiadały w treści słowo/hasztag/zwrot – fake news.

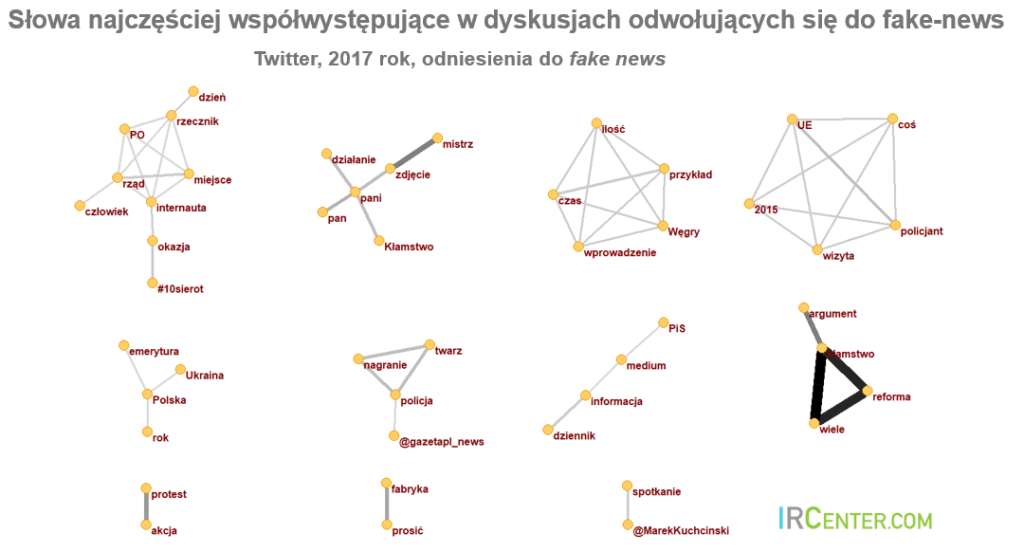

Od stycznia do grudnia 2017 pojawiło się 115 tys. treści z odniesieniem do fake news. Najwięcej z nich – 73% – pojawiło się na Twitterze. Korzystając z najnowszego dostępnego rozwiązania do przetwarzania języka polskiego w ekosystemie R i algorytmów do analiz relacji zidentyfikowaliśmy najczęściej współwystępujące słowa w tweetach i konteksty – tematy określane przez analogiczne słowa. Zidentyfikowane najczęściej współwystępujących słów umożliwia – z pewnym prawdopodobieństwem – identyfikacje podobnych treści.

Algorytmy z największą pewnością wskazywałyby fake news, gdyby trafiały na "kłamstwa o wielu reformach". Niewątpliwie najczęściej jako na fake newsy wskazywałyby też treści o rządzie, PO, rzeczniku/ach, a zwłaszcza takich, które przypominały wzorcową treść okrzykniętą jako fake news w Polsce, czyli aferę 10 sierot. Podejrzane są zdjęcia (określane: „mistrz”), które powodują jako reakcję – okrzyk: „kłamstwo”, a także Węgry i Unia Europejska, a także tematy: emerytura dla Ukraińców i nagrania policji.

Aby móc przyjrzeć się bardziej złożonym strukturom zidentyfikowaliśmy konteksty – grupy wyrazów, które pojawiają się z tą samą regularnością. Te konteksty układają się w cykl życia treści określanych jako fake news:

- źródła fake newsów, moment ich wypłynięcia, najczęściej w związku z reformami prawnymi lub sondażami.

- Dyskusja o nowym fake news niemal zawsze odnosi się do wartości, zasad i innych systemów normatywnych (jako benchmarku dla Polski).

- Skutkiem fake news jest okłamywanie wyborców (w skali masowej do rząd RP najczęściej pojawia się w tym kontekście).

- Osobnymi działaniami są wypowiedzi przedstawicieli rządu i ich dialog z dziennikarzami.

- Negatywne na tym tle odznaczają się eksperci i to, co z Niemiec (media).

- Cykl życia fake news kończy się poprzez sam proces weryfikowania przez media (dziennikarstwo śledcze) i sprostowania osób związanych z tematem.

Czy takie dane umożliwiają detekcję fake news?

Tak, ponieważ w powyższym przypadku zidentyfikowaliśmy treści, przy których pojawiło się oskarżenie o fake news. Wystarczy więc umożliwić algorytmom uczenie się na takim zbiorze, z którego usunięte zostaną po prostu odniesienia do samego fake news. Sami dziennikarze raczej nie będą śledzić fake newsów, ponieważ oni już współtworzą taką dyskusję. Zdecydowanie jest również przestrzeń, żeby 3 sektor mógł monitorować takie dyskusje i uruchamiać określone działania komunikacyjne.

Automatyczna analiza treści tak samo jak do dziennikarstwa, może tak służyć markom i pomagać:

- identyfikować kryzysy na pierwszym etapie,

- poznać struktury kryzysów i dzięki temu minimalizować,

- identyfikować, na którym etapie lejka zakupowego są jakie osoby i zobaczyć, jak różnicuje się język,

- poznawać zbitki słów wspierające kreację i tworzenie treści reklamowych.

Wybór szczegółowych danych i listy słów wyróżniających poszczególne konteksty znajdziecie w dodatkowym materiale do pobrania ze strony ircenter.com

Autor: Albert Hupa, IRCenter.com

Artykuł może zawierać linki partnerów, umożliwiające rozwój serwisu i dostarczanie darmowych treści.

|

|

|

|

|

|

|

|

Stopka

- O nas | Redakcja

- Wywiady | Porady

- Prywatność & cookies

- Mapa serwisu | RSS

© 1998-2026 Dziennik Internautów Sp. z o.o.