Czy globalna moc obliczeniowa AI rzeczywiście zbliża się do 100 zetaFLOPS? AMD twierdzi, że tak, a dwa najszybsze superkomputery świata - El Capitan i Frontier - napędzane układami tej firmy stanowią fundament tej rewolucji. Droga do jottaFLOPS, czyli mocy miliona systemów Frontier, wymaga jednak przezwyciężenia barier energetycznych i architektonicznych.

W skrócie:

- El Capitan osiąga 1,809 eksaFLOPS i prowadzi w rankingu TOP500

- Budowa superkomputera eksaskalowego kosztuje ok. 600 mln dolarów

- NVIDIA kontroluje ponad 80 proc. rynku akceleratorów AI

Dwa amerykańskie systemy AMD na szczycie TOP500

Według najnowszego rankingu TOP500, El Capitan z Lawrence Livermore National Laboratory utrzymuje pozycję lidera z wynikiem 1,809 eksaFLOPS w teście HPL. System HPE Cray EX255a wykorzystuje procesory AMD EPYC i akceleratory Instinct MI300A, osiągając efektywność energetyczną 60,9 GFlops/W.

Drugie miejsce zajmuje Frontier z Oak Ridge National Laboratory (1,353 eksaFLOPS), również oparty na architekturze AMD.

Koszt budowy El Capitan wyniósł około 600 milionów dolarów, a roczne utrzymanie podobnych systemów sięga dziesiątek milionów. To pokazuje skalę inwestycji niezbędnych do utrzymania pozycji w wyścigu o moc obliczeniową.

Czy AMD może zagrozić dominacji NVIDIA w AI?

Mimo sukcesów w segmencie superkomputerów, AMD pozostaje daleko za NVIDIA na rynku akceleratorów AI. Według analiz rynkowych, NVIDIA kontroluje ponad 80 proc. tego segmentu, podczas gdy seria AMD Instinct MI300 zdobyła około 10 proc. udziału w niektórych wdrożeniach chmurowych.

Przychody NVIDIA z centrum danych w Q2 2025 wyniosły 14,5 mld dolarów - wzrost o ponad 170 proc. rok do roku.

AMD MI300X oferuje przewagę w pojemności pamięci - 192 GB HBM3 wobec 80 GB w NVIDIA H100 - co ma znaczenie przy trenowaniu dużych modeli językowych. Jednak ekosystem CUDA i głęboka integracja z frameworkami AI dają NVIDIA trudną do przebicia przewagę.

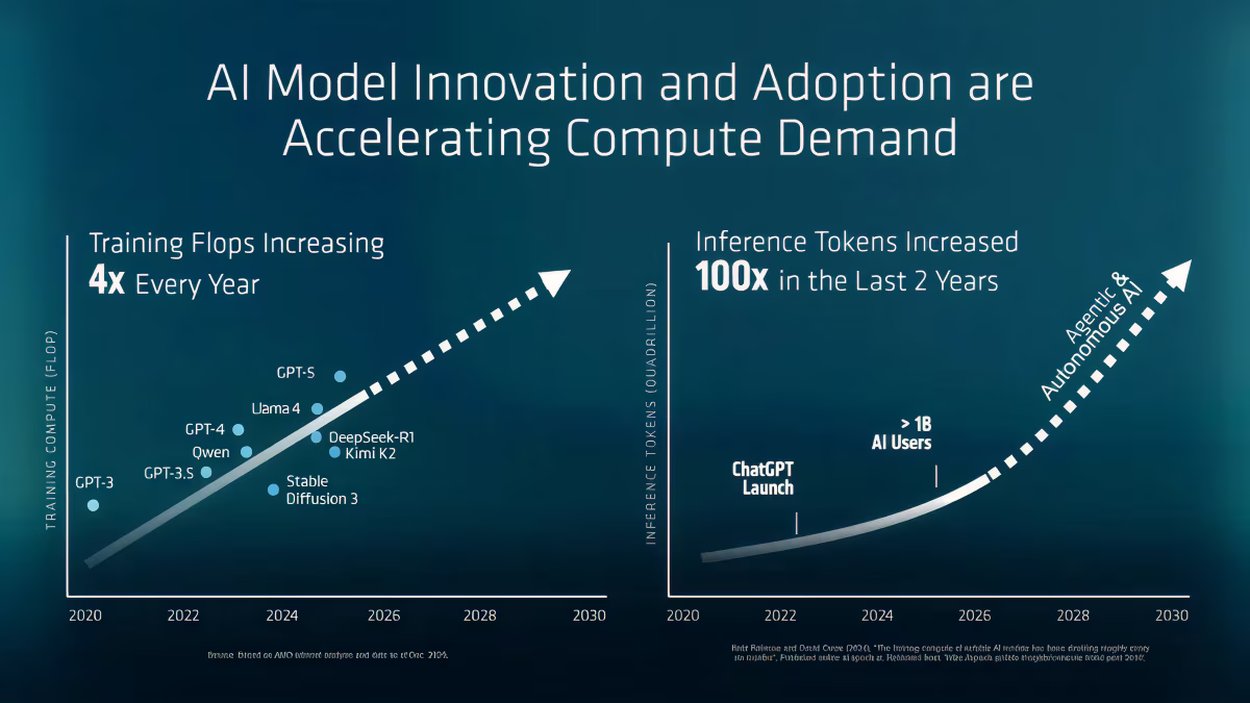

Jak pokazuje analiza rynku danych AI, zapotrzebowanie na moc obliczeniową będzie rosło wykładniczo.

Droga do jottaFLOPS - wyzwania technologiczne

AMD promuje wizję globalnej mocy obliczeniowej AI na poziomie jottaFLOPS, czyli miliona systemów klasy Frontier. Firma wskazuje na platformy rackowe jak AMD Helios jako odpowiedź na rosnące wymagania. Jednak osiągnięcie tego celu wymaga rozwiązania kilku problemów:

- Efektywność energetyczna - najlepsze systemy osiągają 70-73 GFlops/W

- Chłodzenie - eksaskalowe instalacje wymagają zaawansowanych systemów

- Przepustowość komunikacji między modułami

- Koszty - budowa i utrzymanie liczone w setkach milionów dolarów

Europa uruchomiła własny superkomputer eksaskalowy JUPITER, osiągający do 90 eksaFLOPS w zastosowaniach AI. System wspiera projekty od prognozowania klimatu po tworzenie europejskich modeli językowych.

Warto zapamiętać

- AMD dominuje w TOP500, ale NVIDIA kontroluje rynek akceleratorów AI

- Superkomputery eksaskalowe kosztują setki milionów dolarów

- Trend zmierza ku zintegrowanym platformom rackowym zamiast pojedynczych akceleratorów

- Efektywność energetyczna staje się równie ważna jak surowa moc obliczeniowa

Źródło: AMD, TOP500.org, TRG Datacenters

Artykuł może zawierać linki partnerów, umożliwiające rozwój serwisu i dostarczanie darmowych treści.

|

|

|

|

|

|

|

|

Stopka

- O nas | Redakcja

- Wywiady | Porady

- Prywatność & cookies

- Mapa serwisu | RSS

© 1998-2026 Dziennik Internautów Sp. z o.o.