Boom na sztuczną inteligencję sprawia, że centra danych zużywają coraz więcej energii. W odpowiedzi na to wyzwanie AMD ogłosiło przekroczenie ambitnego celu 30x25 – zakładającego 30-krotną poprawę efektywności energetycznej AI i HPC w pięć lat. Teraz firma stawia sobie nowy cel: 20-krotną poprawę efektywności całych racków serwerowych do 2030 roku. Czy branża nadąży za tak szybkim tempem zmian – i co to oznacza dla przyszłości AI?

Cel 30×25 zrealizowany z nadwyżką

W 2021 roku AMD ogłosiło plan 30×25 – pięcioletni program zwiększenia wydajności energetycznej węzłów AI i HPC trzydziestokrotnie względem roku 2020.

W połowie 2025 roku firma ogłosiła przekroczenie tego celu. Na bazie konfiguracji z czterema GPU AMD Instinct™ MI355X oraz procesorem EPYC™ 5. generacji uzyskano:

- 38-krotny wzrost efektywności energetycznej,

- redukcję zużycia energii o ok. 97% dla tej samej operacji obliczeniowej,

- rezultat 2,5× szybszy niż średni trend w branży z lat 2015–2020.

Osiągnięcie było możliwe dzięki m.in. architektonicznym innowacjom, optymalizacji stosunku wydajności do poboru mocy oraz ścisłej integracji CPU i GPU.

Nowa ambicja: 20× poprawy na poziomie racka do 2030

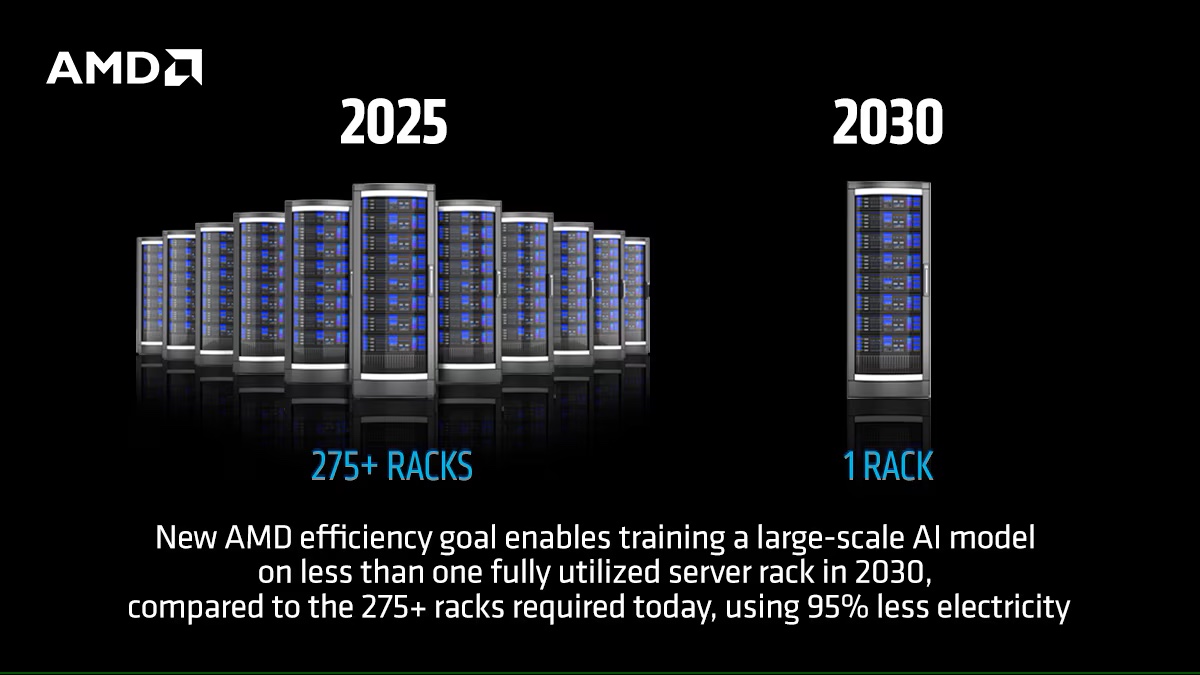

Wobec gwałtownego wzrostu zapotrzebowania na moc AI, AMD przesuwa punkt ciężkości z pojedynczych węzłów na całościowe systemy serwerowe. Nowy cel: 20× poprawa efektywności energetycznej na poziomie całych racków do 2030 r. (bazowy rok: 2024).

W praktyce ma to oznaczać:

- konsolidację z ponad 275 racków do 1 przy trenowaniu dużych modeli AI,

- redukcję zużycia energii o ponad 95%,

- zmniejszenie emisji CO₂ z 3000 do ok. 100 ton na trening.

„Ugruntowanie celu na 2030 rok w metrykach dla całego systemu i przejrzystej metodologii to podniesienie poprzeczki dla całej branży. Zakładane usprawnienia efektywności w skali racka umożliwią innym – od twórców modeli po dostawców chmury – skalowanie AI w sposób zrównoważony.” — dr Jonathan Koomey, Koomey Analytics

Od układów po całe systemy

Nowoczesna infrastruktura AI nie kończy się na chipach. Współczesne centra danych wymagają pełnej integracji:

- akceleratorów GPU, CPU, pamięci i nośników danych,

- efektywnej sieci wewnętrznej oraz systemów chłodzenia,

- sprzętu projektowanego w synergii z oprogramowaniem (hardware-software co-design).

– wynika z materiałów AMD.

Równolegle firma deklaruje wsparcie dla otwartego ekosystemu – zarówno w zakresie sprzętu, jak i oprogramowania (np. środowisko ROCm™).

Oprogramowanie – ukryty motor optymalizacji

Nowy cel AMD koncentruje się na sprzęcie, ale firma zaznacza, że efektywność może dodatkowo wzrosnąć dzięki algorytmom i zmianom w oprogramowaniu.

Szacowany potencjał dodatkowy:

- nawet 5× poprawy efektywności dzięki nowym technikom trenowania,

- łączna poprawa do 100× do 2030 roku (sprzęt + software),

- obniżenie precyzji operacji (np. FP32 → INT8) bez utraty jakości modeli.

To podkreśla rolę współpracy między producentami sprzętu a zespołami ML/AI i twórcami frameworków.

Krytyczne spojrzenie: ograniczenia i realia wdrożeń

1. Tempo adopcji

Choć wyniki AMD są imponujące, odnoszą się do najnowszych układów dopiero wchodzących na rynek. Wiele centrów danych nadal bazuje na starszych, mniej efektywnych platformach. Pełna adopcja wymaga czasu, inwestycji i dostosowania infrastruktury.

2. Skokowe zapotrzebowanie na energię

Międzynarodowa Agencja Energetyczna szacuje, że globalne zużycie energii przez centra danych może się podwoić do 2030 roku. Nawet przy ogromnych zyskach efektywnościowych, całkowity ślad węglowy sektora może nadal rosnąć.

3. Gęstość energetyczna i chłodzenie

Upakowanie mocy z 275 racków w jednej szafie oznacza kolosalny pobór mocy i wydzielanie ciepła. To wymusza:

- stosowanie chłodzenia cieczą lub zanurzeniowego,

- nowoczesne rozwiązania zasilające,

- integrację z odnawialnymi źródłami energii.

Podsumowanie

Poprzeczka została zawieszona wysoko: zrealizowany cel 30×25 to dowód na postęp technologiczny, ale prawdziwym wyzwaniem będzie realizacja celu 20× w skali całych systemów. Sukces wymaga nie tylko wydajniejszych chipów, lecz także synergii oprogramowania, architektury systemowej i infrastruktury energetycznej.

Jeśli AMD oraz inni liderzy branży sprostają temu wyzwaniu, sztuczna inteligencja przyszłości może być nie tylko potężna, ale i energooszczędna. Kluczowe będzie to, jak szybko reszta rynku nadąży za tą transformacją.

Artykuł może zawierać linki partnerów, umożliwiające rozwój serwisu i dostarczanie darmowych treści.

Cyfryzacja produkcji w praktyce. Nowoczesne systemy na potrzeby efektywnej produkcji

|

|

|

|

|

|

|

|

Stopka

- O nas | Redakcja

- Wywiady | Porady

- Prywatność & cookies

- Mapa serwisu | RSS

© 1998-2026 Dziennik Internautów Sp. z o.o.